Wie Bots in Zukunft jede Kommunikation zerstören können

Künstliche Intelligenz in den Medien: Welche Gefahren drohen und was wir tun können

Gastbeitrag von Dirk Liebich

Was hat künstliche Intelligenz mit geräuschreduzierenden Kopfhörern zu tun? Ganz einfach: Wie ein Kopfhörer alle Umgebungsgeräusche neutralisiert, so kann auch ein Bot eine komplette, aufwändig realisierte Unternehmenskommunikation oder alle Botschaften eines Nachrichtenmediums oder einer Person für die öffentliche Wahrnehmung komplett auslöschen. Das Prinzip ist das Gleiche, und anhand der Funktionsweise der Kopfhörer möchte ich Ihnen zeigen, welche Gefahren in naher Zukunft in der Kommunikation heraufziehen. Es betrifft alle Unternehmen und Personen, die in irgendeiner Weise im Internet gehört oder gesehen werden wollen oder einen bestimmten Ruf zu verteidigen haben. Wie korrekte Informationen durch gezielte Falschmeldungen buchstäblich eliminiert werden und vom Einsatz von künstlicher Intelligenz in den Medien, davon handelt dieser Beitrag.

Das Grundprinzip, erklärt am geräuschreduzierenden Kopfhörer

In der klassischen physikalischen Sichtweise ist jedes Geräusch eine Menge von Schallwellen. Ein sehr tiefer Ton hat eine sehr lange Wellenlänge, ein sehr hoher Ton eine sehr kurze Wellenlänge. Lange Wellen reisen länger durch Wasser oder Luft, weil sie ihre zugrundeliegenden Energie sehr langsam abgeben, kurze Wellen verschwinden schneller. Das Nebelhorn eines Schiffes hat genau aus diesem Grund einen sehr tiefen Ton, es soll ja schließlich sehr weit reichen.

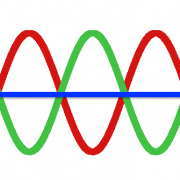

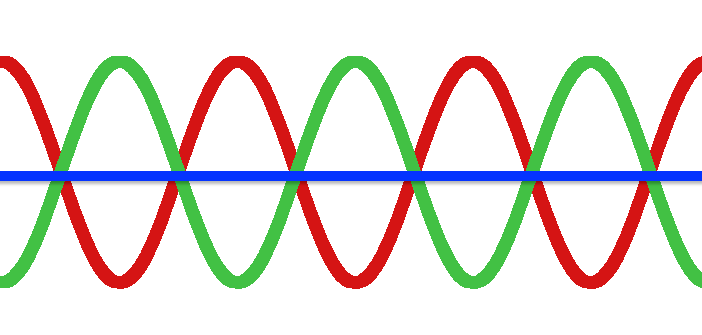

Wenn diese Wellen nun auf das Trommelfell treffen, wird dieses in Schwingung versetzt. Dies erzeugt einen Nervenimpuls, den unser Gehirn dann wieder in einen Ton übersetzt. Soweit so gut. Stellen wir uns nun eine beliebige Welle zu einem bestimmten Zeitpunkt als Form einer Schale vor, dann haben wir von links nach rechts gesehen zum Beginn einen Hochpunkt, laufen nach unten ins Tal und kommen zum Ende wieder nach oben – HOCH-TIEF-HOCH. Stellen wir uns nun die genau gegenteilige Wellenform vor, eben nicht HOCH-TIEF-HOCH, sondern TIEF-HOCH-TIEF, dann würden diese beiden kombiniert einer (Null)Linie gleichen. Die Formen würden sich gegenseitig neutralisieren.

Genau diesem Prinzip folgen geräuschreduzierende Kopfhörer. Ein eingebautes Mikrofon nimmt die Umgebungsgeräusche auf, ermittelt, was stört und erstellt nun ein künstliches Wellenmuster, das genau dem Gegenteil des Störmusters entspricht. Und, schwupps, hören wir letztere nicht mehr. Genial oder?

Der Gegenschall (grün) hebt den Störschall (rot) auf. Die Summe beider Linien (blau): Stille. In diese Stille hinein kann man nun auch neue, eigene Töne senden. Genauso funktioniert das Prinzip auch, wenn man Informationen gezielt auslöschen und durch neue ersetzen will.

Was dieses Prinzip für die digitale Kommunikation bedeutet

Stellen wir uns eine beliebige aktuelle Meldung vor. Eine berühmte Person wurde an Tag X und Zeitpunkt Y an Ort Z gesehen. Um diese Information ins Gegenteil zu verkehren und zumindest als zweifelhaft erscheinen zu lassen, braucht es eigentlich nicht viel mehr als eine glaubhafte, gegenteilige Aussage. Wird diese noch mit einem Bild ausgestattet und mehrfach in unterschiedlichen Bereichen lanciert, wird die Falschmeldung am Ende vermutlich gewinnen. Beispiele hierzu gibt es bereits genug.

Denn der moderne Mensch überprüft seine Informationen intuitiv eher über quantitative Methoden: Was viele verschiedene Quellen behaupten, scheint glaubhafter als eine einzige Nachricht.

Warum kann (und wird!) das zu einem großen Problem werden?

Angesichts der rasanten Entwicklungen im Bereich der künstlichen Intelligenz (KI; englisch: AI = Artificial Intelligence) und in Zeiten von zunehmend günstiger werdender Rechenleistung ist es nur eine Frage der Zeit, wann Maschinen unsere Nachrichtenströme dominieren.

Es wird in einem jetzt noch schwer vorstellbaren Ausmaß dazu kommen, dass Nachrichten gezielt falsch erstellt werden, um eine zuvor definierte Wirkung zu erzeugen. Kommunikation als Instrument für die gezielte Meinungsbildung oder -verhinderung. Maschinenkommunikation als ultrapotentes Mittel, um den Normalbürger zu beeinflusse und zu steuern. Denn für den Einzelnen wird es immer schwieriger “richtig” und “falsch” zu unterscheiden.

Wie ist so etwas möglich, und welche Mittel werden genutzt?

Eine vollständige Antwort mit allen technischen Details würde den Rahmen dieses Artikel sprengen. Daher versuche ich es kurz zusammenzufassen und Ihnen ein wenig Hintergrundinformation und einige Beispiele nicht vorzuenthalten werden. Denn nur wer die Mechanismen versteht, kann dazu beitragen, sie zu entlarven.

Erzählende Wissenschaft, besser bekannt unter dem angloamerikanischen Begriff Narrative Science, ist der systematisierte Weg des Geschichtenerzählens mittels modernster Computertechnik.

Entstanden aus dem Bereich des Natural Language Processing. Komplexe Computermodelle verstehen unsere Sprache im Kontext und sind in der Lage, mit uns zu kommunizieren, ohne dass wir zwingend den Unterschied wahrnehmen können. Jeder von uns hat schon die Bekanntschaft mit dem einen oder anderen Bot gemacht, oft sogar unwissentlich, etwa im Servicechat auf einer Unternehmensseite.

Apples SIRI, Amazons ALEXA und Microsofts CORTANA sind nur einige Beispiele für solche künstliche Intelligenz, die direkt mit uns interagiert und uns den Alltag und die Arbeit erleichtern soll. Noch scheinen die genannten Dienste noch relativ weit davon entfernt, wirklich menschlich reagieren zu können. Doch sie werden sich viel schneller verbessern als wir uns vorstellen können. Zum heutigen Zeitpunkt ist es bereits nur noch eine Frage der Beschickung mit mehr Daten und der damit verbundenen Datenanalyse. Schon jetzt besitzen diese elektronischen Diener ein sehr detailliertes Grundverständnis von Sprache und Kontext.

Sentiment-Analyse: Wie Maschinen lernen, Gefühle zu erkennen

Eines der bekannteren hierbei eingesetzten Verfahren ist die sogenannte Sentiment-Analyse. Die Kurzdefinition hierzu lautet: “Ein Prozess zur rechnerischen Identifizierung und Kategorisierung von durch beliebigen Text ausgedrückte Meinungen. Die Zielsetzung besteht darin herauszufinden, ob die Meinung des Verfassers zu einem bestimmten Thema, Produkt usw. zum Zeitpunkt der Erstellung eher positiv, negativ oder neutral war.”

Die Maschine liest zum Beispiel unsere Produktbewertung auf einer Webseite und klassifiziert, ob wir nach Nutzung desselben gute oder schlechte Laune hatten.

Während frühe Verfahren relativ einfach funktionierten – man hat im Grunde nur Schlüsselwörter wie GUT und SCHLECHT gezählt – liegen heutigen Algorithmen riesige Wortbibliotheken und maschinell erstellte Wort- und Begriffszusammenhänge zugrunde. Während bis vor einigen Jahren die meisten Vorgehensmodelle noch auf komplexen Regelwerken basierten, liegt dies mittlerweile fest in der Hand des sogenannten Machine Learning, einem Unterbereich der künstlichen Intelligenz. Es basiert auf komplexen Netzwerkstrukturen, die ständig wachsen, dazulernen und durch die Beschickung (übrigens auch mit schlechten) Daten immer treffsicherer, intelligenter und letztlich menschenähnlicher “denken”. Die Zukunft der Kommunikation liegt im wahrsten Sinne des Wortes in der Cloud.

Ohne Frage ist der beschriebene Bereich noch sehr jung und im Wesentlichen noch damit beschäftigt, seine Haupteinsatzbereiche zu finden und zu definieren. Aber man braucht sich nur einmal die Liste der in diesem Bereich tätigen Investoren anzuschauen, um ihre Bedeutung zu erkennen. So sind neben den zu erwartenden Größen wie Google und Facebook auch einige Regierungsinstitutionen zu finden. Die Möglichkeiten, die künstliche Intelligenz und Machine Learning versprechen, sind ebenso verlockend wie mächtig.

So können Bots in Zukunft jeden Inhalt neutralisieren und ins Gegenteil verkehren

Aus den beschriebenen Entwicklungen ergeben sich folgende Möglichkeiten:

- Wir können menschliche Kommunikation gezielt verstehen, weil die Auswertung selbst von komplexen Zusammenhängen nur noch eine Frage der eingesetzten Rechenleistung ist, und diese ist ja, wie beschrieben, im Überfluss vorhanden.

- Wer Kommunikation automatisch versteht, bewertet und bis hin zu Emotionen maschinell verstehen kann, kann auf die gleiche Weise (Kommunikations-)Muster erkennen und bei Bedarf ein gegenteiliges Muster erstellen. Damit haben wir den Mechanismus der gezielten Neutralisation unter Kontrolle – wie beim geräuschreduzierenden Kopfhörer.

- Wir können darüber hinaus unsere Nachricht zur dominanten Nachricht machen, indem wir künstlich Gewicht hinzufügen. Diese kann über ein Bild oder die gezielte Verteilung in unterschiedlichen Quellen geschehen. Auch hier ist die Maschine in ihrer Wirkung jeder menschlichen Publikationstätigkeit überlegen.

Anders ausgedrückt: Der gezielten Kommunikation in ungeahnter Dimension steht nichts mehr im Weg. Es ist von nun an eher eine Frage der Zeit, wann das erste Unternehmen mit gezielter (Miss)Kommunikation erpresst wird und für deren Unterlassung in BitCoin bezahlen muss. Das jüngste Beispiel, die amerikanischen Präsidentschaftswahlen, haben sehr deutlich die Möglichkeiten der Massenbeeinflussung aufgezeigt, und wir sprechen hier eher noch von anfänglichen Versuchen; Stichwort: #FakeNews.

Wie schützen sich potenzielle Manipulatoren vor der Entdeckung?

Wer im Verborgenen mit gezielten Falschmeldungen agitiert und manipuliert, braucht eine riesige Rechenleistung, die aber anonym verfügbar sein muss. Abhängig von der Zielsetzung der Kampagne ist eine Verortung der Dienste ja für den Verursacher nicht wünschenswert. Auch hier findet sich schon jetzt ein Beispiel aus dem Alltag.

Sie haben sicher schon häufiger von Angriffen auf Konzern-Webseiten, Regierungswebsites oder auch private Computer gehört. Um diese Angriffe effektiv gestalten zu können, ohne selbst identifizierbar zu sein, haben sich findige IT-Experten (je nach Sichtweise gerne auch mal “Hacker” genannt) die Tatsache zu Nutze gemacht, dass die meisten Computerbenutzer nur Grundkenntnisse mitbringen und deren Rechner damit weitestgehend schutzlos im Internet angebunden sind. Über gezielte Attacken werden diese Computer zu ferngesteuerten Zombie-Rechnern (Bots) in zum Teil riesigen Bot-Netzwerken, mit denen man dann sogar leistungsfähige Infrastrukturen, wie eben die von Konzernen oder Regierungen in die Knie zwingen kann.

Stellen Sie sich beispielsweise den Verlust vor, den ein Online-Casino macht, wenn dessen Website einige Tage nicht erreichbar ist. Viele Institutionen zahlen am Ende lieber schon jetzt Schutzgeld, wie kürzlich beispielsweise in der Hotelbranche bekannt wurde.

Sicherheitslücken ab Werk: Wenn dein Toaster auf Facebook postet

In Zukunft nisten sich solche Bots nicht mehr nur in Ihrem Laptop ein. Auch Ihr internettauglicher Kühlschrank, Toaster, Ihre Zahnbürste machen unter Umständen mit. All diese Geräte haben kleine Computer eingebaut, und diese tun nun einmal, was man ihnen einprogrammiert. Da die Hersteller leider nicht viel Zeit auf Sicherheitsmechanismen verwenden, sind all diese Helfer ein leichtes Ziel und können damit sehr leicht für alles Mögliche missbraucht werden. Ihr Kühlschrank schreibt negierende Twitter-Posts, Ihr Toaster postet auf Facebook, alles ohne ihr Wissen. Unheimlich? Möglicherweise, aber leider Realität.

Es ist also auch ausreichend inoffizielle Kapazität vorhanden (häufig im sogenannten Darknet gehandelt), um in Zukunft Informationsströme gezielt manipulieren zu können.

Manipulation in ungeahnten neuen Dimensionen

Dabei ist das Phänomen selbst ja gar nicht wirklich neu. Nachrichten und auch Falschmeldungen werden schon von jeher auf konkrete Zielsetzungen ausgerichtet und manipulierend eingesetzt. Neu sind jedoch die Dimensionen und die neue Qualität der Möglichkeiten.

Wir, als diejenigen, die Informationen für ihre täglichen Lebensentscheidungen benötigen, werden uns zwischen den Fronten von Roboterlogik wiederfinden. Konzerne, die davon leben ihre Produkte und gesellschaftliche Wertschöpfung zum potentiellen Verbraucher zu kommunizieren, werden sich einer neuen Herausforderung gegenübersehen: Was, wenn der Konkurrent die neuen Möglichkeiten nutzt, um die Kommunikation gezielt zu eliminieren oder, schlimmer noch, ins Gegenteil zu verkehren? Stellen wir uns einmal vor, jede öffentliche Äußerung eines beliebigen Konzerns würde jeweils in einem klassischen #Shitstorm enden. Der Schaden wäre schnell nicht mehr zu verkraften.

Warum Viralität zukünftig planbar wird

Aber wieso soll es auf einmal möglich sein, Aufmerksamkeit für Botschaften oder sogar virale Effekte zu erzielen. Schließlich verstehen wir häufig die Entstehung letzterer immer noch nicht wirklich, und so manche Hoffnung auf große Viralität einer Kampagne oder eines Videos hat sich nicht erfüllt.

Genau an diesem Punkt werden künstliche Intelligenz und schiere Computer-Rechenleistung den Unterschied machen. Manipulierte Nachrichten werden in unterschiedlicher Dichte und über verschiedene Kanäle verbreitet werden. Deren positive oder negative Aufnahme durch den Leser wiederum wird als direkter Rückfluss ins Rechenmodell eingespeist, erlauben die differenzierte Analyse und damit die fortlaufende Verbesserung des zugrundeliegenden Modells. Es ist nur eine Frage der Zeit wann sich auch virale Effekte lückenlos erklären und damit generieren lassen. Vereinfacht ausgedrückt wird es auf eine simple Formel hinauslaufen, über die sich der zu erwartende Effekt beim Verbraucher der Nachricht, der Information beschreiben lässt.

Die schon jetzt vorhandene starke Systemkopplung zwischen Nutzern in sozialen Netzwerken und der werbetreibenden Industrie, die Speicherung von unterschiedlichsten Daten aus unserem täglichen Leben, all dies liefert den beschriebenen Systemen die notwendigen Sensoren in unsere Realität und damit die notwendige Rückkopplung, um die vorhandenen Computermodelle zu verbessern.

Wahrheit oder Fiktion – kaum noch zu unterscheiden?

Dabei sprechen wir zumeist über selbstlernende Systeme. Der Computer benötigt den Menschen nicht mehr! Das Modell bewertet sich selbst. Unsupervised Learning (eigenständiges, nicht überwachtes Lernen) nennt man das.

Konsequent weitergedacht droht eine Gesellschaft inmitten einer vollständig systematisierten Kommunikationserstellung, fast ohne die Möglichkeit, Wahrheit von Fiktion zu unterscheiden. Wie lässt sich den Gefahren entgegentreten?

Jeder Einzelne ist gefragt!

Einfache Lösungen gegen solche Gefahren sind nicht in Sicht. Dieser Art von Kontrollverlust wird man mit Recht und Gesetz kaum beikommen können. Denn in einer Demokratie herrscht ja nun einmal das Recht auf freie Meinungsäußerung. Wir werden neue Wege der Bewertung und Gewichtung von Nachrichten, deren Herkunft und Quellensicherung finden müssen. Jeder von uns wird in viel stärkerem Ausmaß als bisher, die für ausgebildete Journalisten seit Jahren zum Alltag gehören.

Ein wenig Hoffnung kann in der Tatsache gesehen werden, dass Verbraucher heute schon in immer stärkerem Maße der Rückmeldung aus ihren persönlichen Netzwerken vertrauen. Der Trend, Aussagen, Bewertungen, Fragestellungen über die sogenannten Peer Groups bestätigen, widerlegen und beantworten zu lassen, schafft zumindest einen gewissen Ausgleich. Die neue Medien und Möglichkeiten liefern also durchaus auch Lösungen.

Trägheit als natürlicher Feind der Wahrheit

Dennoch, schaut man sich unser Alltagsgebahren auf Facebook oder Twitter an, wird schnell klar, dass wir alle im Grunde eher zu Trägheit neigen. Alles muss schnell gehen und möglichst einfach verdaubar sein. Wir glauben zumeist Dinge, die wir in ähnlicher Weise formuliert in unterschiedlichen Kanälen wiederfinden. Darüber hinaus vertrauen wir Institutionen oder Individuen, die sich über Jahre einen guten Namen durch korrekte Informationsverbreitung gemacht haben.

Aber wie lange werden diese Quellen die gewohnte Qualität aufrecht erhalten können? Es wird schlicht an ausreichend Zeit fehlen, die Masse der Informationen zu bewerten. Es ist nur konsequent, dass sich auch die Gegenmaßnahmen der genannten Mechanismen und Systeme bedienen müssen – ein Wettlauf.

Aktive Gegenmaßnahmen statt Verschwörungstheorien

Es hilft nichts, in der Art von Verschwörungstheoretikern die neuen Technologien anzuprangern. Im Gegenteil: Ich will nicht die unglaublichen Fortschritte und positiven Aussicht im Bereich KI und Machine Learning in Zweifel ziehen.

Es ist aber für unsere Zukunft in einer freien Welt nötig, sich auch mit möglichen negativen Konsequenzen auseinanderzusetzen, um eine neue Wahrnehmung zu erlangen. Dabei ist es wichtig, ein gewisses Grundverständnis für das enorme Manipulationspotenzial zu entwickeln, um diesem zukünftig nicht vollständig ausgeliefert zu sein.

Es ist keine Frage mehr, ob Computermodelle die moderne Kommunikation übernehmen werden, sondern nur noch wann. Nur wenn wir diese Mechanismen verstehen und begreifen, dass wir dieselben Technologien nutzen müssen, um schädlichen Einflüssen entgegenzuwirken, haben wir die Zukunft unserer Kommunikation in der Hand. Schließlich wollen wir nicht zum Spielball von Konzernen und Regierungen werden. Es ist an uns zu entscheiden, ob wir Statisten bleiben oder führende Rollen übernehmen.

Dirk Liebich ist weltweit tätig als Berater und Spezialist rund um das Thema Digitale Transformation. Er gründete unter anderem eine amerikanisch-deutsche Unternehmensberatung und mehrere Start-ups. Durch den gezielten Einsatz von Data Mining, Machine Learning und Business-Intelligence-Lösungen sowie Leadership-Entwicklung, hilft er Unternehmen im Umgang mit der Transformation. Dirk Liebich bloggt, publiziert und hält Vorträge in englischer und deutscher Sprache. Website

Dirk Liebich ist weltweit tätig als Berater und Spezialist rund um das Thema Digitale Transformation. Er gründete unter anderem eine amerikanisch-deutsche Unternehmensberatung und mehrere Start-ups. Durch den gezielten Einsatz von Data Mining, Machine Learning und Business-Intelligence-Lösungen sowie Leadership-Entwicklung, hilft er Unternehmen im Umgang mit der Transformation. Dirk Liebich bloggt, publiziert und hält Vorträge in englischer und deutscher Sprache. Website

– Blog

– Flipboard

– Twitter

- „Das Spielen mit KI ist ein Lernmotor und schafft Gemeinschaft“ - 22. April 2025

- Wie viel KI brauchen Corporate Influencer? - 9. April 2025

- Proof of Concept: Was taugt meine Social-CEO-Strategie? - 10. März 2025